こんにちは,株式会社Ridge-iのリサーチチームの@machinery81です. 今回はNeurIPS2020で発表されたデータセットシフトを扱う機械学習に関連する論文を紹介します.

本記事は,Ridge-i主催の論文読み会で発表した以下の資料に基づいています.

- TL;DR

- 機械学習におけるデータセットシフト

- Taxonomy of NeurIPS2020 papers about Dataset Shift

- 論文紹介

- Rethinking Importance Weighting for Deep Learning under Distribution Shift

- Measuring Robustness to Natural Distribution Shifts in Image Classification

- CSI: Novelty Detection via Contrastive Learning on Distributionally Shifted Instances

- On the Value of Out-of-Distribution Testing: An Example of Goodhart's Law

- データセットシフトを扱うライブラリの紹介:TorchDrift

- データセット シフトについて参考になる書籍など

- 今後の話題

- さいごに

- 参考文献

TL;DR

- 機械学習におけるデータセットシフトの問題設定を整理し,簡単に説明

- NeurIPS2020に採択されたデータセットシフトを扱う論文をカテゴライズ

- NeurIPS2020に採択されたデータセットシフトを扱う論文の中から,気になったものをピックアップして紹介

- データセットシフトを扱うPyTorchライブラリであるTorchDriftを紹介

機械学習におけるデータセットシフト

以下では[Moreno-Torres et al., 2012]による分類に従って,以下のデータセットシフトの問題設定を紹介します.

- Covariate Shift

- Target Shift

- Concept Shift

- Sample Selection Bias

- Domain Shift

Covariate Shift

共変量シフトとも呼ばれ,[Shimodaira, 2000]によって報告・整理されたデータセットシフトの問題設定のうちの一つです.

定義(Covariate Shift)

定義から,分かるように共変量シフトの問題は学習時とテスト時で入力変数の周辺分布が異なるという問題設定を扱います.

例として,以下のようにある人の住んでいる都道府県からその人の年収を予測するという問題を考えてみます.

ここで学習データとテストデータはそれぞれ東北地方と九州地方から集められ,構築されると仮定します. このような問題において,共変量シフト仮定は,学習データとテストデータ内の東北/九州データの占める割合がそれぞれ異なるという場合に該当します. また,表から東北地方と九州地方の平均年収は大体同じであることがわかるので,結局学習時とテスト時に異なるのが入力変数(住んでいる都道府県)の周辺分布だけという状況になることがわかります.

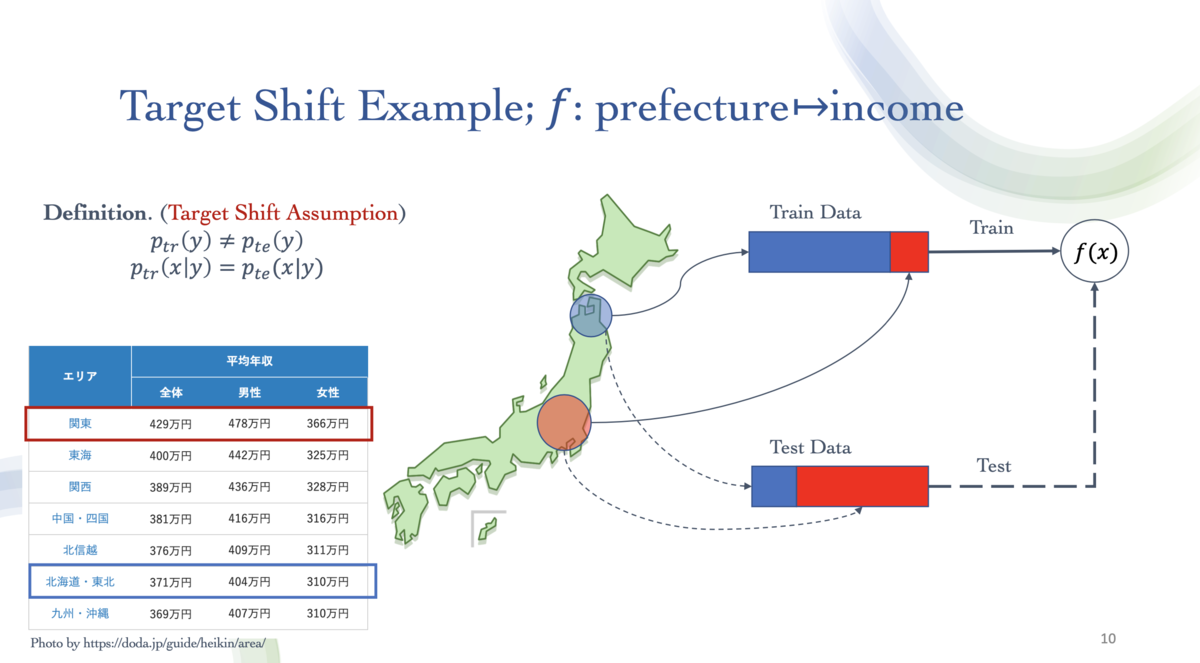

Target Shift

次に,Target ShiftまたはLabel Shiftと呼ばれる問題設定を紹介します. 平たく言うと,Target Shiftは共変量シフトと対になっているような問題設定になります.

定義(Target Shift)

定義から,共変量シフトの場合とは逆に,Target Shiftの問題は学習時とテスト時で出力変数の周辺分布が異なるという問題設定を扱うことになります.

共変量シフトの場合と同様に,ある人の住んでいる都道府県からその人の年収を予測するという問題を考えてみます.

今度は,学習データとテストデータが東北地方と関東地方から収集されているという状況を考えます. この時Target Shift仮定は,学習データとテストデータ内の東北/関東データの占める割合がそれぞれ異なるという場合に該当します. また,図から分かるように,この場合においてTarget Shiftの問題は共変量シフトの問題も内包していることがわかり,それぞれのデータセットシフトの概念は必ずしも独立ではないことが分かると思います.

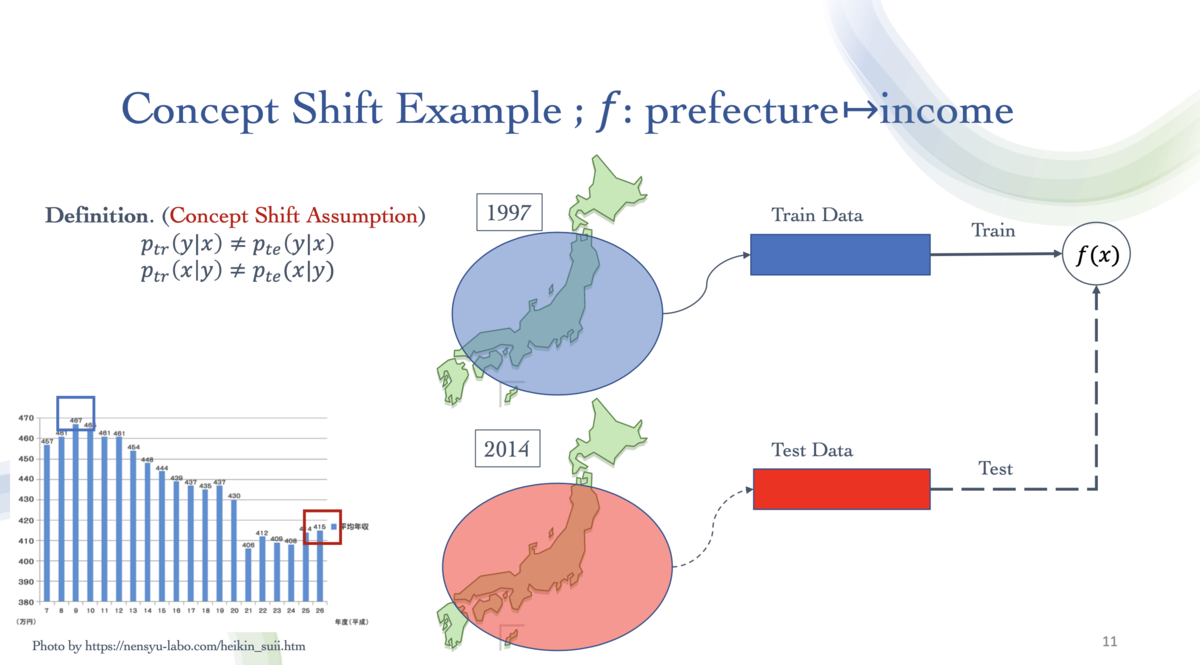

Concept Shift

Concept Shiftはこれまでよりも複雑な問題設定にあたります.

定義(Concept Shift)

定義から,Concept Shiftの問題は学習時とテスト時で条件付き分布が異なるという問題設定を扱うことになります.

これまでと同様に,ある人の住んでいる都道府県からその人の年収を予測するという問題を考えてみます.

今回は,学習データとテストデータはどちらも全ての都道府県から一様に構成され,それらの偏りは無いものとします. ただしConcept Shiftの問題設定では,学習データとテストデータが作られた年代が異なると仮定します. 日本における平均年収は年を追うごとに右肩下がりとなっていることが報告されており,このような場合に学習データを1997年のデータから,テストデータを2014年のデータから構成すると,同じ入力変数(都道府県)にもかかわらず出力変数(年収)が大きく異なってしまうという状況が発生します. これは,1997年から2014年までの歳月の移り変わりの中で,都道府県の平均年収という概念そのものが変わってしまったとも言えます. この,概念が変わるという状況が条件付き確率が変わるという問題設定に該当し,Concept Shiftと命名される由縁になっています.

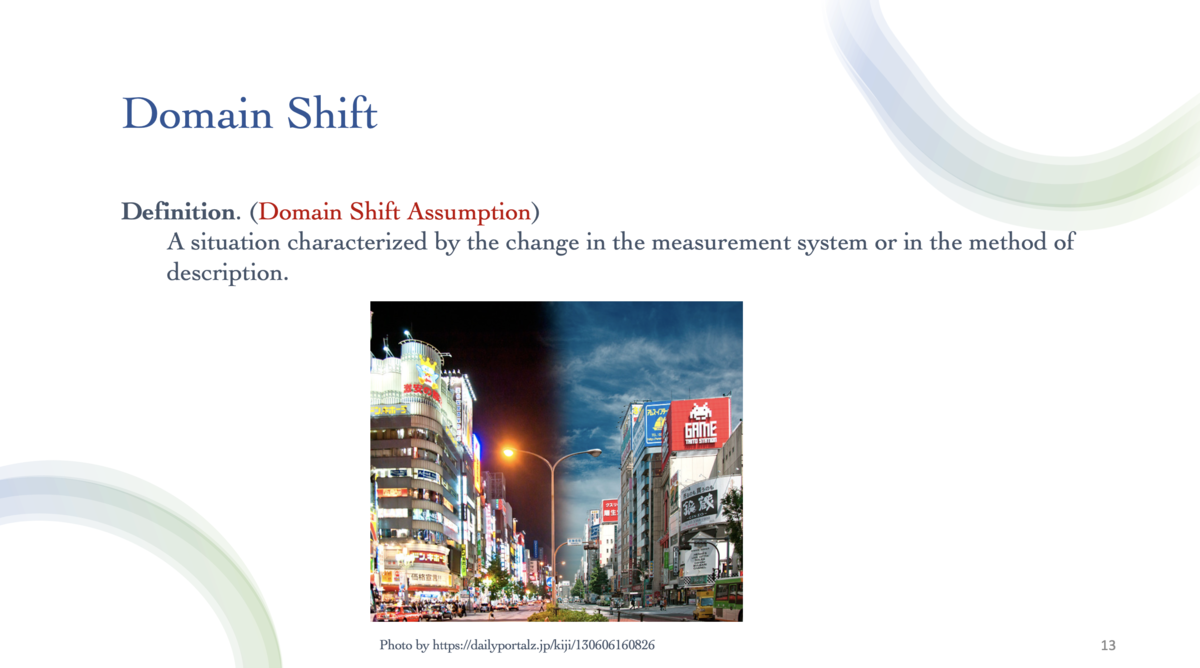

Domain Shift

もう一つ,特にコンピュータービジョンやディープラーニングを伴う研究で頻繁に扱われる問題設定であるDomain Shiftを紹介します.

Domain Shiftは,潜在的に同じものを説明しているにもかかわらず,計測技術や環境の違いなどの影響で変数が異なってしまっているという問題設定に該当します.

例えば以下の画像のように,コンピュータービジョンにおける画像認識の問題を例にとるとわかりやすいです.

写真としては同じ景色(潜在的に同じもの)を撮影しているにもかかわらず昼夜の違い(環境の違い)によって写り方が異なってしまっているという状況です. このような問題は特にVisual Domain Adaptationとして解かれることも多く,直感的な問題設定のわかりやすさと現実世界における登場頻度の高さから人気のタスクの一つとなっています.

Sample Selection Bias

Sample Selection Biasは,これまでとは異なり,データセットシフトが発生する原因について焦点を当てたものです.

定義(Sample Selection Bias)

定義から,Sample Selection Biasは,観測データをデータセットに含めるかどうかを決める隠れた関数が存在し,この関数が学習時とテスト時で異なるという問題設定に該当します.

例えばクラウドソーシングなどでデータセットを作成する際に,クラウドワーカーによってあるデータを学習データに含めるかどうかの基準が異なることなどに起因して発生するデータセットシフトの現象になります.

Taxonomy of NeurIPS2020 papers about Dataset Shift

ここでは,NeurIPS2020におけるデータセットシフトを扱う論文を,より細かいタスクごとに分類します.

Covariate Shift, Target Shift, Concept Shift

- Uehara, Masatoshi, Masahiro Kato, and Shota Yasui. n.d. “Off-Policy Evaluation and Learning for External Validity under a Covariate Shift.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Fang, Tongtong, et al. "Rethinking Importance Weighting for Deep Learning under Distribution Shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Reisizadeh, Amirhossein, et al. "Robust Federated Learning: The Case of Affine Distribution Shifts." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

Meta-Analysis of Distribution Shift

- Taori, Rohan, et al. "Measuring robustness to natural distribution shifts in image classification." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Kulinski, Sean, Saurabh Bagchi, and David I. Inouye. "Feature Shift Detection: Localizing Which Features Have Shifted via Conditional Distribution Tests." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

Domain Adaptation

- Tachet des Combes, Remi, et al. "Domain Adaptation with Conditional Distribution Matching and Generalized Label Shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Chen, Yining, et al. "Self-training Avoids Using Spurious Features Under Domain Shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Kang, Guoliang, et al. "Pixel-Level Cycle Association: A New Perspective for Domain Adaptive Semantic Segmentation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Venkat, Naveen, et al. "Your Classifier can Secretly Suffice Multi-Source Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Zhang, Kun, et al. "Domain adaptation as a problem of inference on graphical models." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Cui, Shuhao, et al. "Heuristic Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Park, Kwanyong, et al. "Discover, Hallucinate, and Adapt: Open Compound Domain Adaptation for Semantic Segmentation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Ge, Yixiao, et al. "Self-paced contrastive learning with hybrid memory for domain adaptive object re-id." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Balaji, Yogesh, Rama Chellappa, and Soheil Feizi. "Robust Optimal Transport with Applications in Generative Modeling and Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Saito, Kuniaki, et al. "Universal domain adaptation through self supervision." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Wang, Ximei, et al. "Transferable Calibration with Lower Bias and Variance in Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Combes, Remi Tachet des, et al. "Domain adaptation with conditional distribution matching and generalized label shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Luo, Yawei, et al. "Adversarial style mining for one-shot unsupervised domain adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

Sampling Bias, Selection Bias

- Purushwalkam, Senthil, and Abhinav Gupta. 2020. “Demystifying Contrastive Self-Supervised Learning: Invariances, Augmentations and Dataset Biases.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Mazaheri, Bijan, Siddharth Jain, and Jehoshua Bruck. 2020. “Robust Correction of Sampling Bias Using Cumulative Distribution Functions.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Flanigan, Bailey, Paul Gölz, Anupam Gupta, and Ariel Procaccia. 2020. “Neutralizing Self-Selection Bias in Sampling for Sortition.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

Out-Of-Distribution Detection

- Tack, Jihoon, et al. "CSI: Novelty Detection via Contrastive Learning on Distributionally Shifted Instances." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Teney, Damien, et al. "On the Value of Out-of-Distribution Testing: An Example of Goodhart's Law." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Jeong, Taewon, and Heeyoung Kim. "OOD-MAML: Meta-Learning for Few-Shot Out-of-Distribution Detection and Classification." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Nandy, Jay, Wynne Hsu, and Mong Li Lee. "Towards Maximizing the Representation Gap between In-Domain & Out-of- Distribution Examples." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Bitterwolf, Julian, Alexander Meinke, and Matthias Hein. "Certifiably Adversarially Robust Detection of Out-of-Distribution Data." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Kirichenko, Polina, Pavel Izmailov, and Andrew Gordon Wilson. "Why normalizing flows fail to detect out-of-distribution data." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Xiao, Zhisheng, Qing Yan, and Yali Amit. "Likelihood regret: An out-of-distribution detection score for variational auto-encoder." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Liu, Weitang, et al. "Energy-based Out-of-distribution Detection." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

こうしてみると,やはりDomain Adaptationが人気で,次点でOut-Of-Distribution Detectionと呼ばれるタスクに注目が集まっていることがわかります.

論文紹介

以下ではいくつか論文をピックアップして紹介したいと思います.

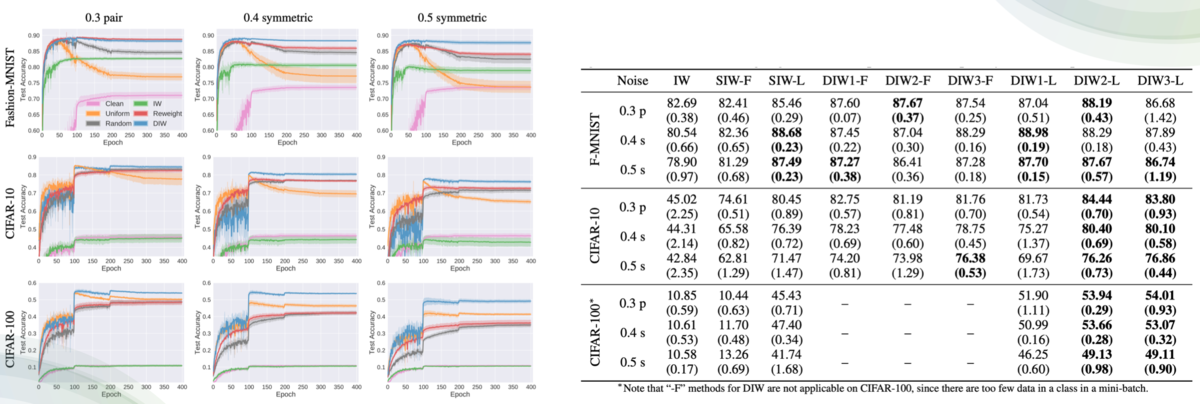

Rethinking Importance Weighting for Deep Learning under Distribution Shift

- データセットシフトを扱うための本質的なテクニックとして,学習データの各サンプルに適切に重要度重み付けをするImportance Weightingが挙げられる.

- しかし,Importance WeightingはDeep Learningが扱うような複雑なデータに対しては計算が難しいという問題がある.

- 論文では,このImportance WeightingをDeep Learningの枠組みでも扱うことができるような手法を提案した.

Importance Weighting for Distribution Shift

データセットシフトを扱うためのテクニックとして,Importance Weightingは非常に本質的なアイディアとして知られています.

Covariate ShiftやTarget Shiftでみたように,学習時とテスト時で分布が異なるという設定はそもそもデータセットに占める各属性のサンプルの割合が異なることによるものでした(例えば,データセットに占める都道府県の割合). これを解決する非常に単純な方法としては,テストデータに多く含まれるようなサンプルの重みを大きくして学習を行うという戦略が思いつくと思います.

実際,重要度重み付けとして学習分布とテスト分布の密度比を採用することで,重み付き関数の学習分布における期待値が元の関数のテスト分布における期待値に一致することが証明されます.

例えば,共変量シフトを例にとると,以下のような式変形によってこれが確かめられると思います.

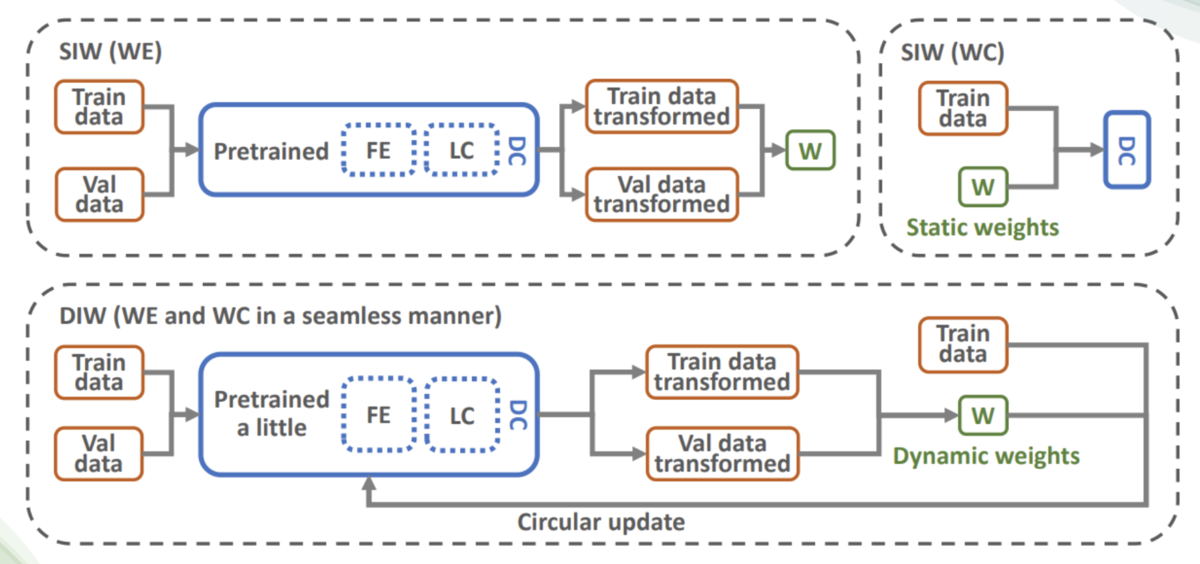

ここでImportance Weightingは以下の2ステップに分解されます:

- 重みまたは密度比

を推定するImportance Estimation

- 重み

を利用して学習または分類を行うWeighted Classification

Deep Learningで扱われるような複雑なデータを対象とする場合,このうち1. Importance Estimationが問題になります. データの重要度重みを適切に推定するには,そのデータを十分説明できるような表現力の高い関数が必要になります. そのような関数は一般に閉形式では与えられないので,例えばニューラルネットワークを用いた特徴抽出器を学習して活用するといった方針が考えられます.

しかしここで問題となるのが,そうした重要度重み付けを獲得するために必要な特徴抽出器の学習そのものにも重要度重み付けが必要になってしまうという点です.

論文ではニワトリとタマゴのジレンマとして触れられ,Circular Dependency問題と呼ばれています. つまり,

- 重要度重み付けを獲得するためには特徴抽出器が必要

- 特徴抽出器を獲得するためには重要度重み付けが必要

という,まさに循環参照のような状況が発生してしまうわけです.

論文ではこれを解決するため,

- 少しだけ事前学習を行った特徴抽出器で重要度重み付けを獲得

- 1.で獲得した重要度重み付けを用いて特徴抽出器を少しだけ更新

- 2.で獲得した特徴抽出器を用いて重要度重み付けを少しだけ更新

- 以上を収束するまで繰り返す

という戦略をとっています.

実験結果から,複数のタスクでこの手法の有効性が確かめられています.

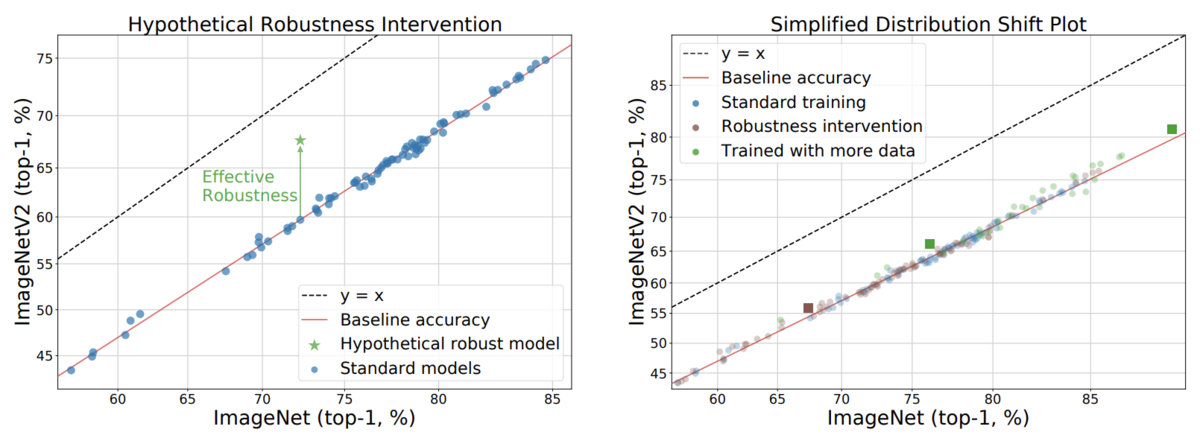

Measuring Robustness to Natural Distribution Shifts in Image Classification

- 既存のデータセットシフトを扱う研究では,テストデータに学習データにはありえない人工的なデータ拡張を施すなどして,データセットシフトの状況を作っていた

- このように人工的なデータセットシフトに対してロバストだった手法が,実際に現実世界で起こりうる自然なデータセットシフトの下ではあまり有効性が確認できなかったことを指摘する論文

既存のデータセットシフトに取り組む研究の多くは,テストデータに学習データにはありえない人工的なデータ拡張を施すなどして,データセットシフトの状況を作り出していました. このような人工的なデータセットシフトの下で,提案手法がロバストであることを報告しているわけですが,このような人工的なデータセットシフトに対するロバスト性は現実世界のデータセットシフトへのロバスト性と同値なのか?という疑問が当然起こりえます.

この論文では,204種類のImageNetに対するモデルと213種類の異なる実験設定の下で大規模な実験を行い,このような人工的なデータセットシフトに対するロバスト性が現実的にはほとんど意味をなさないことを報告しました.

このようなちゃぶ台をひっくり返すような論文は,実際に自分が適用しようとしている手法が本当に自身の解きたいタスクに有効なのかどうかを検証するという意味で非常に価値があると思います.

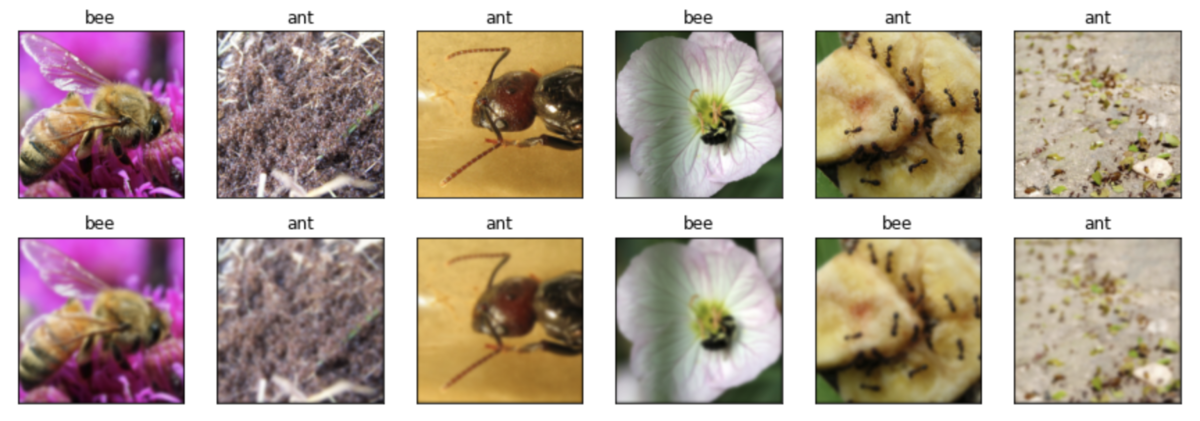

CSI: Novelty Detection via Contrastive Learning on Distributionally Shifted Instances

- Contrastive Learningに基づくOut-Of-Distribution Detectionの手法を提案

Out-Of-Distribution Detectionとは,入力データが学習分布に属するものなのかどうかを識別するという問題設定です.

例えばパンダとテナガザルが学習分布に含まれるようなデータだと仮定した場合は,通常は観測できないような珍しい色をしたパンダや,トラやウマなどパンダでもテナガザルでもない画像,攻撃されたAdversarial ExamplesなどはOut-Of-Distribution画像であると判断されます.

こうしたタスクに取り組む最も直感的かつ有効な手段として,学習データ特有の特徴を表現学習し,入力データがこの特徴を持たないことを根拠としてOut-Of-Distributionデータを検出するという戦略です.

ところで,近年人気の表現学習のフレームワークに,Contrasive Learningというものがあります.

これは,例えば犬の画像の特徴を表現学習したいという時に,

- 犬画像に数種類のデータ拡張を適用して特徴抽出器に通し,それらが特徴空間上で近くなるように学習

- 犬以外の画像に数種類のデータ拡張を適用して特徴抽出器に通し,それらが特徴空間上で近くなるように学習

- 犬画像と犬以外の画像にデータ拡張を適用して作られた特徴同士は遠くなるように学習

というフレームワークになります.

このアプローチは様々なタスクで有効性が確かめられ,近年非常に人気となっています.

本論文では,このContrasive LearningをOut-Of-Distribution Detectionタスクに適用し,学習データの特徴を表現学習することでタスクを解くことを提案しています.

On the Value of Out-of-Distribution Testing: An Example of Goodhart's Law

- Visual Question AnsweringタスクにおけるOut-Of-Distribution Detectionのベンチマークとして有名なVQA-CPというデータセットが存在する.

- このVQA-CPデータセットの扱い方に関して,多くの既存の論文がバッドプラクティスを犯していることを指摘

Visual Question Answeringとは,画像と質問文のペアが与えられ,画像を考慮しながら質問文に自動で応答するというタスクです. 例えば,野球をプレー中の画像と”男性は何のスポーツをしていますか?”といったクエリから,”野球”と答えるといったタスクが該当します.

このようなタスクにおいて,特に学習分布外のデータを検出するOut-Of-Distribution Detectionを行うためのベンチマークデータセットとしてVQA-CPデータセットがあります.このデータセットは当該タスクにおいてデファクトスタンダートとなっており,多くのVQAにおけるOOD検出を扱う論文がこのデータセットに対する実験結果を報告しています.

しかしながら,本論文では既存の論文によるこのデータセットの扱われ方に不適切な点があることを指摘しています.

そもそもこのデータセットは,例えば画像内でプレーされているスポーツを答えるクエリであれば,学習データにはテニスとスキーの割合が極端に高く,逆にテストデータではそれらの割合が極端に低くなるように作られています. ここで問題となるのは,既存の研究の多くが,この割合がひっくり返るという情報を明示的に利用してしまっているという点です. Out-Of-Distribution Detectionの問題設定は元々,いわゆる異常検知や外れ値検知の問題設定に近く,学習データから分布を構成し,入力データがこの構成された分布に含まれるかどうかを考えるというものでした. しかし既存の多くの研究は,本来活用できないデータ間の割合がひっくり返るという情報を使ってしまっており,適切な性能評価ができていないということをこの論文では指摘しています.

データセットシフトを扱うライブラリの紹介:TorchDrift

PyTorchでデータセットシフトを扱うライブラリであるTorchDriftの紹介をします.

TorchDrift is a data and concept drift library for PyTorch. It lets you monitor your PyTorch models to see if they operate within spec. We focus on practical application and strive to seamlessly integrate with PyTorch.

TorchDriftライブラリでは,Covariate Shift,Target ShiftおよびConcept Shiftを対象としています(What is drift?). このようなデータセットシフトの環境下で,TorchDriftはPyTorchモデルが仕様内で動作するかどうかを監視することを目的としています.

インストールはPyPi経由で以下のコマンドで可能です:

$ pip install torchdrift

また,詳細なAPIはTorchDrift.orgが詳しいです.

ここでは,READMEに記載のコード記述例を紹介します.

# 学習分布を特徴抽出器と学習データローダを用いてフィッティングする drift_detector = torchdrift.detectors.KernelMMDDriftDetector() torchdrift.utils.fit(train_dataloader, feature_extractor, drift_detector) # データセットシフトの検出を行う features = feature_extractor(inputs) score = drift_detector(features) p_val = drift_detector.compute_p_value(features) if p_val < 0.01: raise RuntimeError("Drifted Inputs")

機械学習モデルの社会実装においては,データセットシフトの考慮は今後必須の課題となるはずであり,これを簡易に行えるTorchDriftのようなライブラリの採用は一考の価値があると思われます.

データセット シフトについて参考になる書籍など

- 東大の杉山先生らによって執筆されたデータセットシフトについてよくまとまっている書籍:

- ドメイン適応の理論について網羅した書籍:

今後の話題

本記事では各種データセットシフトの問題設定を整理し,それらを扱った様々なNeurIPS2020採択論文を紹介しました. 一般的に多くの統計学・機械学習の手法はi.i.d.仮定に基づいており,特に学習データとテストデータが同一の分布から生成されることを前提にしています. これは特に教師あり学習の妥当性の基礎になるEmpirical Risk Minimizationなどで顕著であり,なぜ学習データに対する損失関数の最小化がテストデータにおけるモデルの性能を保証するのか?といった,非常に本質的な問題に関わっています.

現実世界への機械学習の応用を考えると,学習データとテストデータが異なる分布から生成されるという状況は決して珍しくなく,学習/テストデータが同一の分布から作られたベンチマークセットにおけるモデルの性能がほぼ飽和してきている昨今では,今後より注目を集める研究分野であることが予想されます.

さいごに

Ridge-iでは様々なポジションで積極採用中です. カジュアル面談も可能ですので,ご興味がある方は是非ご連絡ください.

参考文献

- Moreno-Torres, Jose G., Troy Raeder, Rocío Alaiz-Rodríguez, Nitesh V. Chawla, and Francisco Herrera. 2012. “A Unifying View on Dataset Shift in Classification.” Pattern Recognition 45 (1): 521–30.

- Shimodaira, Hidetoshi. 2000. “Improving Predictive Inference under Covariate Shift by Weighting the Log-Likelihood Function.” Journal of Statistical Planning and Inference 90 (2): 227–44.

- Uehara, Masatoshi, Masahiro Kato, and Shota Yasui. n.d. “Off-Policy Evaluation and Learning for External Validity under a Covariate Shift.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Fang, Tongtong, et al. "Rethinking Importance Weighting for Deep Learning under Distribution Shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Reisizadeh, Amirhossein, et al. "Robust Federated Learning: The Case of Affine Distribution Shifts." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Taori, Rohan, et al. "Measuring robustness to natural distribution shifts in image classification." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Kulinski, Sean, Saurabh Bagchi, and David I. Inouye. "Feature Shift Detection: Localizing Which Features Have Shifted via Conditional Distribution Tests." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Tachet des Combes, Remi, et al. "Domain Adaptation with Conditional Distribution Matching and Generalized Label Shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Chen, Yining, et al. "Self-training Avoids Using Spurious Features Under Domain Shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Kang, Guoliang, et al. "Pixel-Level Cycle Association: A New Perspective for Domain Adaptive Semantic Segmentation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Venkat, Naveen, et al. "Your Classifier can Secretly Suffice Multi-Source Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Zhang, Kun, et al. "Domain adaptation as a problem of inference on graphical models." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Cui, Shuhao, et al. "Heuristic Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Park, Kwanyong, et al. "Discover, Hallucinate, and Adapt: Open Compound Domain Adaptation for Semantic Segmentation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Ge, Yixiao, et al. "Self-paced contrastive learning with hybrid memory for domain adaptive object re-id." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Balaji, Yogesh, Rama Chellappa, and Soheil Feizi. "Robust Optimal Transport with Applications in Generative Modeling and Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Saito, Kuniaki, et al. "Universal domain adaptation through self supervision." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Wang, Ximei, et al. "Transferable Calibration with Lower Bias and Variance in Domain Adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Combes, Remi Tachet des, et al. "Domain adaptation with conditional distribution matching and generalized label shift." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Luo, Yawei, et al. "Adversarial style mining for one-shot unsupervised domain adaptation." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Purushwalkam, Senthil, and Abhinav Gupta. 2020. “Demystifying Contrastive Self-Supervised Learning: Invariances, Augmentations and Dataset Biases.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Mazaheri, Bijan, Siddharth Jain, and Jehoshua Bruck. 2020. “Robust Correction of Sampling Bias Using Cumulative Distribution Functions.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Flanigan, Bailey, Paul Gölz, Anupam Gupta, and Ariel Procaccia. 2020. “Neutralizing Self-Selection Bias in Sampling for Sortition.” 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Tack, Jihoon, et al. "CSI: Novelty Detection via Contrastive Learning on Distributionally Shifted Instances." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Teney, Damien, et al. "On the Value of Out-of-Distribution Testing: An Example of Goodhart's Law." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Jeong, Taewon, and Heeyoung Kim. "OOD-MAML: Meta-Learning for Few-Shot Out-of-Distribution Detection and Classification." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Nandy, Jay, Wynne Hsu, and Mong Li Lee. "Towards Maximizing the Representation Gap between In-Domain & Out-of- Distribution Examples." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Bitterwolf, Julian, Alexander Meinke, and Matthias Hein. "Certifiably Adversarially Robust Detection of Out-of-Distribution Data." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Kirichenko, Polina, Pavel Izmailov, and Andrew Gordon Wilson. "Why normalizing flows fail to detect out-of-distribution data." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Xiao, Zhisheng, Qing Yan, and Yali Amit. "Likelihood regret: An out-of-distribution detection score for variational auto-encoder." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Liu, Weitang, et al. "Energy-based Out-of-distribution Detection." 34th Conference on Neural Information Processing Systems (NeurIPS) 2020. Neural Information Processing Systems, 2020.

- Bulusu, Saikiran, et al. "Anomalous example detection in deep learning: A survey." IEEE Access 8 (2020): 132330-132347.

- Chen, Ting, Simon Kornblith, Mohammad Norouzi, and Geoffrey Hinton. 2020. “A Simple Framework for Contrastive Learning of Visual Representations.” In Proceedings of the 37th International Conference on Machine Learning, edited by Hal Daumé Iii and Aarti Singh, 119:1597–1607. Proceedings of Machine Learning Research. PMLR.