こんにちは,株式会社Ridge-iの@obaradsです.本記事では点群処理における表現学習手法について紹介します.また,本記事は@machinery81にレビューしていただきました.

TL;DR

- 点群ための深層学習モデルに対する表現学習手法について紹介

- 点群処理分野における表現学習手法の目的について説明

表現学習とは

表現学習とは,機械学習において生の入力データから何らか意味のある特徴ベクトルまたは特徴ベクトルへの写像を獲得するフレームワークの一種です.ここで得られる特徴ベクトルは基本的には下流のタスクで利用されるため,これらの良し悪しは下流タスクで達成される性能によって評価されることが多いです.また,表現学習によって獲得される特徴ベクトルが持つべき望ましい性質はいくつかありますが,そのうち重要なものとして以下の2つが挙げられます:

- 不変性:入力データの小さな(局所的な)変化に対しては,特徴ベクトルの変化も小さくあることが望ましい.

- 抽象性:入力データの抽象的な特性をうまく抽出して特徴空間の上にマッピングされることが望ましい.

これらの性質が満足されるような表現学習は,抽象的に似ている入力データ同士が近くに,異なるデータ同士は遠くにマッピングされるような特徴空間を生成します.

点群で表現学習を扱う理由

点群で表現学習を行う目的としては,主に以下のようなものがあります:

- 点群の特徴の生成

- ラベル付きデータが制限されている状況下におけるモデルの性能向上

- 点群間の対応点を見つけるための表現学習

本記事ではこれらに関連した論文を紹介していきます.

点群の特徴の生成

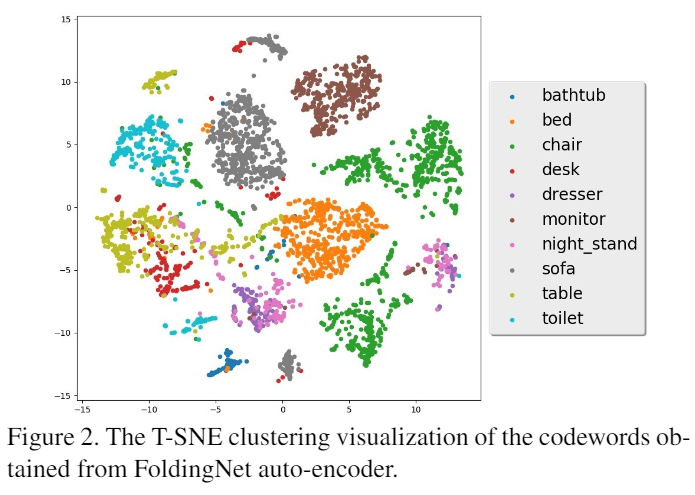

提案したネットワーク構造や学習方法によって点群データをよく表現する特徴が得られているかどうかを調べる簡易な方法として,点群から特徴(e.g. 中間表現)を抽出し,その特徴が識別的な表現であるかどうか評価するといったものがあります.評価はサポートベクトルマシンや視覚化などの手法を介して行われ,結果が良かった場合は対象のネットワーク構造が入力された点群の形状特徴を適切に捉えられているとみなすことができます.また,上記のような評価手法としての利用以外にも,物体を映した点群(オブジェクト点群)などの3D表現データを検索する際にこれらの中間表現を利用することも有用であると考えられます[Funkhouser et al, 2003].

ラベル付きデータが制限されている状況下におけるモデルの性能向上

最近では,事前学習やドメイン適応などを目的とした表現学習手法が点群深層学習の分野で提案されています.また,これらのほとんどは教師なし表現学習として提案されています.こうした学習手法が提案されている理由としては,ラベル付きデータについての制約が挙げられます.この文脈では,セマンティックセグメンテーションタスクなどで使われる風景を映した点群(シーン点群)に対するアノテーションが非常に高価で時間がかかるという背景があります.

例として,SemanticKITTI[Behley et al, 2019]と呼ばれる自動運転の目的で取得したLiDAR点群データセットがあります.このデータセットは様々な論文でベンチマークテストとして扱われるほどの品質を持つものの,その品質を実現するのに合計で1700時間以上もの時間がかけられています.

点群の深層学習モデルの性能向上を必要とするにしても,コストがかかるデータのアノテーションは避けられるに越したことはありません.そこで,モデルの性能向上が期待できる表現学習手法が注目されるようになりました.

点群間の対応を見つけるための表現学習

点群のレジストレーションタスクで点群間の位置対応を見つけるため,点群間で重複する点同士の特徴が類似するように学習する手法が提案されています.レジストレーションタスクは一部の点が重複し尚且つ別々の座標系を持つ二つの点群が与えられたとき,この二つの点群を同じ座標系に置くための推定をするというものです.このとき,重複する箇所の点から抽出された特徴が点群間で似たものである場合,その2つの点は点群間で位置的に対応しているとみなすことができます.そのような点の特徴を出力できるような関数を得るために,多くの場合は深層学習が活用されています.なお,対応関係を探すために任意に選ばれた点をここではinterest pointと呼びます.

例えば下の図では,点群Aから選択したinterest pointとその周りの形状から記述子(特徴)を生成し,点群Bでも同じ方法で記述子を取得します.その後,点群間の記述子で比較して表現が近しい記述子を列挙しています.この手法では,点群間で位置的に重複するinterest point同士を近しい表現にするように深層モデルを学習させています.

表現学習方法について

この記事で扱う論文の多くは以下の2つのフレームワークに大別されます:

- 再構築タスクによる学習

- Contrastive learning

再構築タスクによる学習

このフレームワークでは,AutoEncoder[Hinton et al, 2006]のような生成モデルを使った再構築タスクによる学習を行います.この学習では,モデルに入力された点群と同じ点群を推定できるようにすることを目標としており,再構築タスクによる学習後,モデルのエンコーダー部分が点群が示す形状特徴を抽出できるようになることが仮定されています.

Contrastive Learning

Contrastive Leaerningは2021年現在において有力な表現学習フレームワークの一つで,入力データ同士で共通する基準を設け,それに従った学習を行います.例えば,与えられたオブジェクト同士が同じクラスに属するかどうかという基準で学習させていくことになります.具体的には,モデルにオブジェクトを入力し,同じクラスに属するオブジェクト同士は特徴空間上で近く,異なるクラスに属するオブジェクト同士は特徴空間上で遠くにマッピングされるように学習を行なっていきます.このフレームワークは非常に強力であり,点群以外の分野でも広く活用されています. 例えば以下の記事では,Contrasive Learningをデータセットシフト問題に取り組むために採用している論文を紹介しています.

点群の表現学習に関する文献紹介

点群処理への深層学習の適用以前の特徴量の算出

点群処理に深層学習手法が適用される以前は,人が記述した特徴算出手法(hand-crafted特徴)が提案されていました.例えば,ある点を中心としてその周りにある点の情報(法線など)や相対距離を計算して,その結果を特徴量として利用するといった方法がありました.他にも,ある点を中心としていくつかのビンを持つヒストグラムを形成する方法や複数視点からの特徴生成も存在します.

~2017年:PointNetが提案される以前の表現学習手法

深層学習の登場により,点群を用いた表現学習手法が提案されました.しかしながら,2017年以前の手法は点群を深度画像などの別の表現に変換することを前提とした処理になっています.この処理は点群データを2D画像やそれを拡張した3Dボクセルのネットワークに適用させるために必要でした.

3DMatch[Zeng et al, 2016]では,再構築された点群からinterest pointを作成し,そのinterest pointにふさわしい記述子を学習する手法を提案しています.この手法では,interest point周りの点群を体積表現に直し,その体積表現を入力とする3D CNNによって記述子を取得します.記述子自体の学習は,対応する点のContrastive learningによって行われます.この手法では事前にデータセットで学習させた深層学習モデルを別のデータセットで再学習させて評価しています.この評価では既存の手法よりも優れた結果が得られることを報告しており,事前の表現学習の重要性を示しました.

LORAX[Elbaz et al, 2017]では,レジストレーションタスクにおける点群間の対応箇所を探すために,AutoEncoderを用いた局所領域の特徴抽出を行っています.この手法では切り取られた点群を深度画像に変換後,深度画像をAutoEncoderに入力し,出力を入力深度画像と比較して表現学習を行います.その後,表現学習済みのAutoEncoderから取得された中間表現を点群間の対応箇所検索に利用します.

2017~2019年:PointNetが提案されて以降の生成モデルを用いた表現学習手法

点群を他の表現に変換せずに処理ができるPointNet[Qi et al, 2017]の提案以降,汎用性の高さからPointNetの考えを基本にした点群の深層学習モデルの提案が増えていきました.そのうち,AutoEncoderを用いた再構築タスクによる表現学習手法がいくつか提案されています.これらの研究では再構築タスクに対する評価以外にも点群をAutoEncoderで学習させた後にエンコーダーだけを利用して評価する実験が行われました.

[Achlioptas et al, 2018]では,PointNetを利用したAutoEncoderで再構築タスクによる表現学習を行っており,GAN[Goodfellow et al, 2014]のアーキテクチャを用いた形状生成を検証しています.また,AutoEncoderに対する表現学習を行ったのち,学習されたエンコーダーとSVMを用いてModelNet[Wu et al, 2015]の分類タスクを解く実験も行っています.この実験では,hand-crafted特徴や点群を他の表現に変換して処理する既存の手法よりも著者らの提案が優れていることを報告しています.

SO-Net[Li et al, 2018]やFoldingNet[Yang et al, 2018]では新規のエンコーダーとデコーダーを用いたAutoEncoderを提案しました.これらはAutoEncoderを使った再構築タスクで提案モデルの表現学習を行い,ModelNetの分類タスクを下流タスクとして扱い評価しています.

また,3D点群に対する既存の深層学習モデルの潜在特徴が一つだけに依存していることを指摘し,それに対処するためのモデルとして3D-PointCapsNet[Zhao et al, 2019]が提案されました.これは画像処理分野で利用されているCapsule Network[Sabour et al, 2017]を点群処理に応用したモデルで,下図の様に複数の潜在特徴を持つことを利点としています.

単体オブジェクトに対する表現学習以外にも,シーン点群の一部分(パッチ)をPoint Pair Feature (PPF)[Drost et al, 2010]に変換したのちに,そのPPFをモデルに入れてPPFそのものを再構築するPPF-FoldNet[Deng et al, 2018]と呼ばれるモデルが提案されています.この手法はレジストレーションを下流タスクとして扱い,精度の改善を実験で示しました。

2019~2020年:自己教師あり学習を利用した表現学習手法

点群をそのまま処理する深層学習手法において,これまでは再構築タスクを使った表現学習手法が台頭していましたが,2019年以降から再構築タスク以外の表現学習手法を利用する提案がなされるようになっていきました.再構築タスクのみの手法とそれ以外の既存研究では以下のような差があります。

| 再構築タスクのみ | それ以外 | |

|---|---|---|

| 提案 | 新規のアーキテクチャの提案が中心 | アーキテクチャ以外の学習手法の提案が中心 |

| 下流タスク | ほとんどは分類とパーツセグメンテーション,レジストレーションは少し | 分類とパーツセグメンテーション,セマンティックセグメンテーション,物体検出 |

| 表現学習で使うデータ | 単体オブジェクト点群がほとんど,シーン点群は少し | 単体オブジェクト点群とシーン点群 |

それ以外の手法では,主に2D画像処理分野で提案された表現学習の一種である自己教師あり学習手法をベースとしています.

[Sauder et al, 2019]の手法はその代表例であり,2D画像処理分野で提案されたジグソーパズルを解く手法[Noroozi et al. 2016]に基づいています.この手法では空間上で配置を入れ替えた点群に対して,ネットワークはこれらの点群の元の位置を予測するというタスクを表現学習のために行います. 著者らは,点が増えた際のAutoEncoderの損失関数の計算量の増加や[Achlioptas et al., 2018]が実験で示した症状の存在に対して,本提案はこれらの問題を回避した手法であると主張しています.

また,[Hassani et al, 2019]の手法はDeep Clustering系列の手法[Caron et al. 2018, Dizaji et al. 2017]のアイデアをベースとしたマルチタスク(分類,クラスタリング,再構築)を解く手法を提案しています.こちらは,Deep Clusteringを用いた分類やクラスタリング問題で起こるtrivial solutionsを回避するために再構築タスクを与えています.

Contrastive Predictive Coding[Oord et al, 2018]やDeep InfoMax[Hjelm et al, 2019]のアプローチを利用した手法もあり,Info3D [Sanghi, 2020]で提案されています.この提案では,点群を含む3Dオブジェクトデータに対して回転不変な埋め込みを得るための表現学習手法としてアプローチを利用しています.

2020年~:シーン点群に着目した表現学習手法

ここまでの論文の手法では,主に点群の単体オブジェクトに対するタスクを解くための表現学習が扱われていました.シーンに対する表現学習手法はあまり扱われておらず,あるとしてもレジストレーションのような比較的簡易なタスクに対する提案や小規模なセマンティックセグメンテーションの実験[Sauder et al, 2019]が行われた程度でした.

シーン点群のタスクの中でより難解なタスク(セマンティックセグメンテーションや物体検出など)に対する表現学習をメインとした研究はPointContrast[Xie et al., 2020]によって進みだしました.論文の著者らはFCGF[Choy et al, 2019]の学習方法を点群深層学習モデルの表現学習手法として利用し,6つのドメインの違うデータセットでこの学習手法が表現学習手法として役に立つことを示しました.

FCGFは点群のレジストレーションタスクに対する提案です.レジストレーションタスクでの既存の手法は,与えられる点群の一部(パッチ)の記述子を得るために,パッチを深層学習モデルに複数入力する方法が取られていました.しかしながら,この処理では深層モデルの受容野がパッチ内のみに制限される可能性がありました. これらの問題を解決するため,FCGFではFully-convolutional network (FCN)のデザインを持つシンプルなアーキテクチャの利用とContrastive learningに基づく損失関数を提案しました.この手法では以下の学習処理が行われます:

- 与えられる点群が2つであるとき,各点群をパッチサイズに分割せずに,各点群をFCNライクなモデルに入力して点群の点ごとの特徴を得る.

- 2つの点群からアンカーと呼ばれる点を選ぶ.

- 与えられる点群間で位置的に対応しているアンカー同士(ポジティブペア)が類似した記述子を持つように,対応していないアンカー同士(ネガティブペア)とは別々の記述子になるようにモデルを学習を行う.

この処理により,ネットワークはパッチによる制限を受けずなおかつ点レベルの記述子を得ることができるようになりました.

PointContrastでは,FCGFの以下の点に注目し,この手法を表現学習手法として利用した事前学習済みネットワークの検証を行いました.

- パッチによる受容野の制限が無い点:深層学習モデルの機構に対して制限がかからない.

- 対応点さえ用意できれば学習できる点:点群間で共通した座標系を得るのはカメラの位置推定等で可能,セグメンテーションで必要となるようなラベルは必要ないため,ラベル付きデータの作成が高コストな点群処理分野でも十分使える.

実験ではScanNet[Dai et al, 2017]を表現学習に使い,ShapeNet[Angel et al., 2015]を用いた分類タスクからS3DIS[Armeni et al, 2016]を用いたセマンティックセグメンテーションタスクまで幅広い実験を行い,その有効性について示しました.

PointContrastの論文に続いて,Shape Context記述子の分割領域に従って損失の計算を行う手法[Hou et al, 2020]も提案されました.こちらはPointContrastの学習方法に以下の制約があるのではないかという仮説を立てました:

- 複雑なタスク(e.g. インスタンスセグメンテーション)で重要となる空間コンテキスト(ここでは相対距離や角度のことを指す)を考慮した損失計算がなされていないこと.

- 利用するアンカーの総数を増やしても有用な結果を得られない事実があり,これはContrasive Learningで利用するペアの計算に,実空間上で距離が離れている(互いに関係性が薄い)ペアの計算を含んでいることが影響していること.

これらの問題に対して,著者らはContrasive Learningの際に利用する特徴の数を絞るためにShape Context記述子を使うことを提案しました.提案では,アンカーを中心としてShape Context記述子(下図)を設けることで,そのアンカーと比較する点をShape Context記述子の範囲内にある点を絞り,なおかついくつかの空間(ビン)に分割することができます.このビンと範囲の制約に基づくContrasive Lossの計算により,上記の制約の影響を緩和したことを示しました.

これらの問題を解決するために,DepthContrast[Zhang et al, 2021]が提案されました.この手法では,ある風景に対して一つまたは複数の視点から取得した点群で表現学習を行うことができます.またPointContrastの点ごとの損失計算とは違い,こちらは与えられたシーン点群全体の特徴を用いて損失計算を行うため,2つの点群間の対応点を見つける必要がないという利点も挙げられます.

上記のようにシーン点群を表現学習に使うことを想定した提案がある一方で,生成モデルを利用した単一視点から取得した点群(2.5D点群)から完全な3D点群を復元する,点群深層学習モデル向けの表現学習を行った研究[Wang et al, 2020]も報告されています.この論文はオブジェクト点群に対する生成モデルを利用した表現学習手法を扱っているものの,実験ではシーン点群に対するセマンティックセグメンテーションの評価実験を行っています.これは,2019年以前と違い,シーン点群を利用した難解なタスクへの利用に関心が向けられてきているとみなすことができます.

まとめと今後の傾向

3D空間上のデータを工夫して深層学習モデルに入力することから始まり,PointNetを基としたモデルの提案,自己教師あり学習の導入と表現学習の研究も変化してきました. そして,PointContrastの大規模な検証によって実世界のデータを利用した表現学習済みモデルが様々なタスクで有用であることがわかりました.

PointContrastでの検証以降,この学習で使われている対応点や対応シーンに基づくContrastive learningをベースとした提案がいくつかなされています.そのうちの一つとして,別表現間から得た特徴表現間で損失の計算を行うといったものがあります.ここで言う別表現というのは,ボクセルや点群などの入力表現の違いを指し,上記の説明ではDepthContrastが当てはまります.DepthContrastでは3D表現間で学習を行っていますが,この他にも2DのRGB画像と点群間で学習を行うものもあります.その手法としてpixel-to-point knowledge transfer (PPKT)[Liu et al. 2021]が提案されており,この手法では2D RGB画像の事前学習済みネットワークを3Dネットワークの事前学習に利用することを目的としています.

今後,この表現間の違いに着目した提案はいくつか行われると思われます.筆者としては,教師なしによって表現学習用のデータに様々なデータを利用することを踏まえ,2.5D表現と3D表現点群の差に着目した研究が出現すると考えています。

さいごに

Ridge-iでは様々なポジションで積極採用中です. カジュアル面談も可能ですので,ご興味がある方は是非ご連絡ください.

参考文献

- Jonathan Sauder and Bjarne Sievers. Self-Supervised Deep Learning on Point Clouds by Reconstructing Space. In Advances in Neural Information Processing Systems (NeuralPS), 2019.

- Mehdi Noroozi and Paolo Favaro. Unsupervised Learning of Visual Representations by Solving Jigsaw Puzzles. In European Conference on Computer Vision (ECCV), pages 69-84, Springer, 2016.

- Kaveh Hassani and Mike Haley. Unsupervised Multi-Task Feature Learning on Point Clouds. In International Conference on Computer Vision (ICCV), pages 8159-8170, 2019.

- Kamran Ghasedi Dizaji, Amirhossein Herandi, Cheng Deng, Weidong Cai and Heng Huang. Deep clustering via joint convolutional autoencoder embedding and relative entropy minimization. In International Conference on Computer Vision (ICCV), pages 5736–5745, 2017.

- Mathilde Caron, Piotr Bojanowski, Armand Joulin, and Matthijs Douze. Deep clustering for unsupervised learning of visual features. In European Conference on Computer Vision (ECCV), pages 132–149, 2018.

- Panos Achlioptas, Olga Diamanti, Ioannis Mitliagkas, and Leonidas J. Guibas. Learning Representations and Generative Models for 3D Point Clouds. In Proceedings of the 35th International Conference on Machine Learning (ICML), PMLR 80:40-49, 2018.

- R Devon Hjelm, Alex Fedorov, Samuel Lavoie-Marchildon, Karan Grewal, Phil Bachman, Adam Trischler and Yoshua Bengio. Learning deep representations by mutual information estimation and maximization. In International Conference on Learning Representations (ICLR), 2019.

- Aaron van den Oord, Yazhe Li and Oriol Vinyals. Representation Learning with Contrastive Predictive Coding. arxiv, 2018.

- Aditya Sanghi. Info3D: Representation Learning on 3D Objects using Mutual Information Maximization and Contrastive Learning. In European Conference on Computer Vision (ECCV), 2020.

- Saining Xie, Jiatao Gu, Demi Guo, Charles R Qi, Leonidas J Guibas and Or Litany. Pointcontrast: Unsupervised pretraining for 3d point cloud understanding. In European Conference on Computer Vision (ECCV), 2020.

- Christopher Choy, Jaesik Park and Vladlen Koltun. Fully Convolutional Geometric Features. In International Conference on Computer Vision (ICCV), pages 8957-8965, 2019.

- Ji Hou, Benjamin Graham, Matthias Nießner and Saining Xie. Exploring Data-Efficient 3D Scene Understanding with Contrastive Scene Contexts. arxiv, 2020.

- Charles R. Qi, Hao Su, Kaichun Mo and Leonidas J. Guibas. PointNet: Deep Learning on Point Sets for 3D Classification and Segmentation. In Conference on Computer Vision and Pattern Recognition (CVPR), pages 77-85, 2017.

- Hinton, G E and Salakhutdinov, R R. Reducing the dimensionality of data with neural networks. science, 5786, pages 504-507, 2006.

- Jiaxin Li, Ben M. Chen, Gim Hee Lee. SO-Net: Self-Organizing Network for Point Cloud Analysis. In Conference on Computer Vision and Pattern Recognition (CVPR), pages 9397-9406.

- Yaoqing Yang, Chen Feng, Yiru Shen and Dong Tian. FoldingNet: Point Cloud Auto-Encoder via Deep Grid Deformation. In Conference on Computer Vision and Pattern Recognition (CVPR), pages 206-215, 2018.

- Wu, Zhirong, Shuran Song, Aditya Khosla, Fisher Yu, Linguang Zhang, Xiaoou Tang, and Jianxiong Xiao. 2015. “3d Shapenets: A Deep Representation for Volumetric Shapes.” In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 1912–20.

- Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville and Yoshua Bengio. Generative Adversarial Nets. In Advances in Neural Information Processing Systems (NeuralPS), 2014.

- Drost, Bertram, Markus Ulrich, Nassir Navab, and Slobodan Ilic. 2010. “Model Globally, Match Locally: Efficient and Robust 3D Object Recognition.” In 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 998–1005.

- Deng, Haowen, Tolga Birdal, and Slobodan Ilic. 2018. “Ppf-Foldnet: Unsupervised Learning of Rotation Invariant 3d Local Descriptors.” In Proceedings of the European Conference on Computer Vision (ECCV), 602–18.

- Sara Sabour, Nicholas Frosst and Geoffrey E Hinton. Dynamic Routing Between Capsules. In Advances in Neural Information Processing Systems (NeuelPS), pages 3856–3866, 2017.

- Yongheng Zhao, Tolga Birdal, Haowen Deng and Federico Tombari. 3D Point Capsule Networks. In Conference on Computer Vision and Pattern Recognition (CVPR), pages 1009-1018, 2019.

- Elbaz, Gil, Tamar Avraham, and Anath Fischer. 2017. “3D Point Cloud Registration for Localization Using a Deep Neural Network Auto-Encoder.” In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 4631–40.

- Zaiwei Zhang, Rohit Girdhar, Armand Joulin and Ishan Misra. Self-Supervised Pretraining of 3D Features on any Point-Cloud. arxiv. 2021.

- Hanchen Wang, Qi Liu, Xiangyu Yue, Joan Lasenby and Matthew J. Kusner. Unsupervised Point Cloud Pre-Training via View-Point Occlusion, Completion. arxiv. 2020.

- Thomas Funkhouser, Patrick Min, Michael Kazhdan, Joyce Chen, Alex Halderman, David Dobkin, and David Jacobs. 2003. A search engine for 3D models. ACM Trans. Graph. 22, 1 (January 2003), 83–105. DOI:https://doi.org/10.1145/588272.588279.

- Dai, Angela, Angel X. Chang, Manolis Savva, Maciej Halber, Thomas Funkhouser, and Matthias Nießner. 2017. “Scannet: Richly-Annotated 3d Reconstructions of Indoor Scenes.” In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 5828–39.

- Chang, Angel X., Thomas Funkhouser, Leonidas Guibas, Pat Hanrahan, Qixing Huang, Zimo Li, Silvio Savarese, et al. 2015. “ShapeNet: An Information-Rich 3D Model Repository.” arXiv [cs.GR]. arXiv. http://arxiv.org/abs/1512.03012.

- Armeni, Iro, Ozan Sener, Amir R. Zamir, Helen Jiang, Ioannis Brilakis, Martin Fischer, and Silvio Savarese. 2016. “3D Semantic Parsing of Large-Scale Indoor Spaces.” In 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE. https://doi.org/10.1109/cvpr.2016.170.

- Choi, Sungjoon, Qian-Yi Zhou, Stephen Miller, and Vladlen Koltun. 2016. “A Large Dataset of Object Scans.” arXiv [cs.CV]. arXiv. http://arxiv.org/abs/1602.02481.

- Gadelha, Matheus, Rui Wang, and Subhransu Maji. 2018. “Multiresolution Tree Networks for 3d Point Cloud Processing.” In Proceedings of the European Conference on Computer Vision (ECCV), 103–18.

- Liu, Yueh-Cheng, Yu-Kai Huang, Hung-Yueh Chiang, Hung-Ting Su, Zhe-Yu Liu, Chin-Tang Chen, Ching-Yu Tseng, and Winston H. Hsu. 2021. “Learning from 2D: Pixel-to-Point Knowledge Transfer for 3D Pretraining.” arXiv [cs.CV]. arXiv. http://arxiv.org/abs/2104.04687.

- Dahnert, Manuel, Angela Dai, Leonidas J. Guibas, and Matthias Niessner. 2019. “Joint Embedding of 3d Scan and Cad Objects.” In Proceedings of the IEEE/CVF International Conference on Computer Vision, 8749–58. openaccess.thecvf.com.

- Maaten, Laurens van der and Geoffrey Hinton. 2008. “Visualizing Data Using T-SNE.” 2008. https://www.jmlr.org/papers/volume9/vandermaaten08a/vandermaaten08a.pdf.

- Behley, Jens, Martin Garbade, Andres Milioto, Jan Quenzel, Sven Behnke, Cyrill Stachniss, and Jurgen Gall. 2019. “Semantickitti: A Dataset for Semantic Scene Understanding of Lidar Sequences.” In Proceedings of the IEEE/CVF International Conference on Computer Vision, 9297–9307.

- Zeng, Andy, Shuran Song, Matthias Nießner, Matthew Fisher, Jianxiong Xiao, and Thomas Funkhouser. 2016. “3DMatch: Learning Local Geometric Descriptors from RGB-D Reconstructions.” arXiv [cs.CV]. arXiv. http://arxiv.org/abs/1603.08182.

- 橋本 学 (2014). 物体認識のための 3 次元特徴量の基礎と動向. ビジョン技術の実利⽤ワークショップ ViEW2014. URL: http://isl.sist.chukyo-u.ac.jp/islweb-pre/Archives/ViEW2014SpecialTalk-Hashimoto.pdf (アクセス: 2021/05/17)